使用builtwith即可以查看所有网站的主题,源码和插件,自然也包含Shopify。

总的来说,不管是直接查看源码还是使用网站查询,其实原理都是查看对方wordpress网站的源码,从而在源码中提些主题信息,奥博说推荐用最后的方式,因为不仅可以查询Wordpress,还有Shopify及其他任何源码的主题和插件。

总的来说,不管是直接查看源码还是使用网站查询,其实原理都是查看对方wordpress网站的源码,从而在源码中提些主题信息,奥博说推荐用最后的方式,因为不仅可以查询Wordpress,还有Shopify及其他任何源码的主题和插件。

Google’s new page experience signals combine Core Web Vitals with their existing search signals. These include:

If you need a refresher, Google’s Core Web Vitals are comprised of three factors:

These ranking factors can be measured in a report found in Google Search Console, which shows you which URLs have potential issues:

There are plenty of tools to help you improve your site speed and Core Web Vitals, the main one being Google PageSpeed Insights.

Webpagetest.org is also a good place to check how fast different pages of your site are from various locations, operating systems, and devices.

Some optimizations you can make to improve website speed include:

Second, you’ll want to be sure your site is free from any crawl errors. Crawl errors occur when a search engine tries to reach a page on your website but fails.

You can use Screaming Frog or other online website crawl tools–there are many tools out there to help you do this. Once you’ve crawled the site, look for any crawl errors. You can also check this with Google Search Console.

When scanning for crawl errors, you’ll want to…

a) Correctly implement all redirects with 301 redirects.

b) Go through any 4xx and 5xx error pages to figure out where you want to redirect them to.

Bonus: To take this to the next level, you should also be on the lookout for instances of redirect chains or loops, where URLs redirect to another URL multiple times.

Poor link structure can cause a poor user experience for both humans and search engines. It can be frustrating for people to click a link on your website and find that it doesn’t take them to the correct–or working–URL.

You should make sure you check for a couple of different factors:

links that are 301 or 302 redirecting to another page

links that go to a 4XX error page

orphaned pages (pages that aren’t being linked to at all)

An internal linking structure that is too deep

To fix broken links, you should update the target URL or remove the link altogether if it doesn’t exist anymore.

The experts at Perfect Search are always on the lookout for these errors and other issues you identify in this technical SEO checklist on your site. Contact us for a free site audit and we’ll help to identify some quick wins and key focus areas–no contract required.

Make sure there’s no duplicate or thin content on your site. Duplicate content can be caused by many factors, including page replication from faceted navigation, having multiple versions of the site live, and scraped or copied content.

It’s important that you are only allowing Google to index one version of your site. For example, search engines see all of these domains as different websites, rather than one website:

– https://www.abc.com

– https://abc.com

– http://www.abc.com

– https://abc.com

Fixing duplicate content can be implemented in the following ways:

Setting up 301 redirects to the primary version of the URL. So if your preferred version is https://www.abc.com, the other three versions should 301 redirect directly to that version.

Implementing no-index or canonical tags on duplicate pages

Setting the preferred domain in Google Search Console

Setting up parameter handling in Google Search Console

Where possible, delete any duplicate content

Back in 2014, Google announced that HTTPS protocol was a ranking factor. Today, if your site is still HTTP, it’s time to make the switch.

HTTPS will protect your visitors’ data to ensure that the data provided is encrypted to avoid hacking or data leaks.

Straight from the mouth of Google: “A site’s URL structure should be as simple as possible.”

Overly complex URLs can cause problems for crawlers by creating unnecessarily high numbers of URLs that point to identical or similar content on your site.

As a result, Googlebot may be unable to completely index all the content on your site.

Here are some examples of problematic URLs:

Sorting parameters. Some large shopping sites provide multiple ways to sort the same items, resulting in a much higher number of URLs. For example:

http://www.example.com/results?search_type=search_videos&search_query=tpb&search_sort=relevance&search_category=25

Irrelevant parameters in the URL, such as referral parameters. For example:

http://www.example.com/search/noheaders?click=6EE2BF1AF6A3D705D5561B7C3564D9C2&clickPage=OPD+Product+Page&cat=79

Where possible, you’ll want to shorten URLs by trimming these unnecessary parameters.

XML sitemaps tell search engines about your site structure and what to index in the SERP.

An optimized XML sitemap should include:

Any new content that’s added to your site (recent blog posts, products, etc.).

Only 200-status URLs.

No more than 50,000 URLs. If your site has more URLs, you should have multiple XML sitemaps to maximize your crawl budget.

You should exclude the following from the XML sitemap:

URLs with parameters

URLs that are 301 redirecting or contain canonical or no-index tags

URLs with 4xx or 5xx status codes

Duplicate content

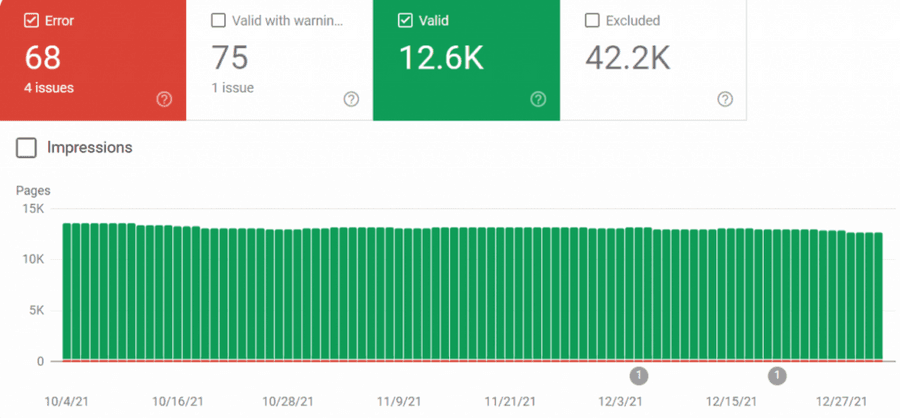

You can check the Index Coverage report in Google Search Console to see if there are any index errors with your XML sitemap:

Robots.txt files are instructions for search engine robots on how to crawl your website.

Every website has a “crawl budget,” or a limited number of pages that can be included in a crawl – so it’s imperative to make sure that only your most important pages are being indexed.

On the flip side, you’ll want to make sure your robots.txt file isn’t blocking anything that you definitely want to be indexed.

Here are some example URLs that you should disallow in your robots.txt file:

Temporary files

Admin pages

Cart & checkout pages

Search-related pages

URLs that contain parameters

Finally, you’ll want to include the location of the XML sitemap in the robots.txt file. You can use Google’s robots.txt tester to verify your file is working correctly.

Structured data helps provide information about a page and its content – giving context to Google about the meaning of a page, and helping your organic listings stand out on the SERPs.

One of the most common types of structured data is called schema markup.

There are many different kinds of schema markups for structuring data for people, places, organizations, local businesses, reviews, and so much more.

You can use online schema markup generators. Google’s Structured Data Testing Tool can help create schema markup for your website.

Even small website changes can cause technical SEO site health fluctuations. Internal and external links break if the anchor text is changed on your internal site or the website that you are pointing to. New website pages or organization, site migrations, and redesigns do not always transfer over important SEO aspects like schema markup, sitemaps, and robots.txt, or move them to a place that Google will not recognize. Make a plan to run a crawl of your site and look at each aspect of this checklist any time major changes are made to your website and on a regular schedule to make sure that organic website traffic is not disrupted by a technical SEO issue.

Are you looking for a partner who can take care of your technical SEO?

We’re here to help!

创造价值,永远不是靠一个技巧,一个诀窍,一个方法,可以做到的。真正的硬通货,无一不是经过大量的时间和大量的经验堆积起来的。这东西才有壁垒,才有长期性。 大部分人,就是哪有钱去哪,没钱的事情宁死不干。这种思路,真的,该着你挣不到钱。 明白人,是一定会知道,想挣到钱,是需要先积累,先付出的。 先付出才能换来经验,而经验最终可以换成钱。 在做任何事的初期,你全部的精力就聚焦在这么一件事上就行了:怎么才能用最短的时间,得到最多的经验。 如果你要做一个能赚钱的付费运动社群,那你最好先做出来一个免费群,去验证规则,去验证流程,去验证可行性,去验证什么方法才能让大家愿意参加,才能让大家喜欢的嗷嗷叫。 这个步骤完成了,再说收费的事儿。 如果你要想变成情感领域的专家,而是又手里没有客户,那你第一个目标,应该是去知乎去免费回答情感问题,做到梳理自己的梳理,也帮别人解决问题,去尽快的接触到更多真实的案例。 如果你要变成出色的离婚律师,那你第一个目标,不是收费验证生意模式,而是去做公益,以免费解决100个人的离婚问题为目标。 当你做了这些事情,你会有足够多的案例、经验、素材。到时候,不管你是制作内容以给自己带来影响力,还是做出来自己的产品。你都会心里非常有谱了。 不要只盯着钱,要盯着的是钱背后的东西:经验。

老婆给我讲了一个她看到的讲有一类在北京的外卖小哥的生活状态。 就这些外卖小哥,一到了晚上,就涌入商场的那种电梯井或者楼梯间。干嘛去?睡觉去。没错他们不租房,因为太贵。劳累一天之后,就卷铺盖卷在大厦楼道睡,因为这里能保温,夏天也能凉快,还有免费水洗漱,还能充电。 就这样的生活,还得早去抢位置,小哥们都知道哪些楼层保安经常来巡视,哪些地方能呆得住。然后早上4、5点,小哥们就会把铺盖卷收拾好,藏在消防井的那种柜子里,再开始新的一天的工作,就这么重复。 这些小哥很清楚,北京待不住,但是希望用能拼的这些年,多给自己和家人攒下点钱。 所以每次我有点什么阻碍,有点不痛快,眼前都会浮现出这样那样的故事,每次想到这,都觉得自己太tm矫情了。就我这点小困难,算个屁。然后就能继续去搬砖没有废话了。 而且每次看到有人在网上说啥,生活太难了,生活不下去了。我也都觉得这些人也都很矫情,生活真正难的人,是不会活跃在互联网上的,他们正在为生活打拼,没有时间到网上发这种矫情文字的。 真正难的人,在互联网中是没有一席之地的,他们既没有能力,也没有时间发声的,他们是真实存在但又不被关注的人。 夜里3点进菜的菜商,住在楼道的外卖小哥,这些人是“隐形”的。有的人来了,有的人走了,他们有着怎样的家人,怎样的悲欢离合的故事,这些我们都不得而知的。 这还没说,那些看不见,身体有重大残疾的人呢。 总之,还能在互联网打字说自己太难的人,无论你怎么难,都可能是世界上某一个角落的某一个人,梦想中的生活了对吗。 所以真的没什么可不知足的。

一个人想获得成功,不管是物质层面的,还是精神层面的,你获得成功主要靠的是你做了什么,不是靠你没做什么。 你当一个好人,你善良,这是内在层面对自己的标准,这里要说但是,但是你作为一个好人,注意,这个只能让你不被人讨厌。 而成功,靠的是你做了什么,你为别人创造了什么价值,有人愿意拿到你的价值,有人愿意为你付费。 你在职场中,没做坑人的事情,对别人彬彬有礼,这些东西正确,但不会让别人特别关注你,赞赏你,奖励你。 重要的是,你解决了什么问题,你创造了什么绩效,你创造了什么产品什么价值。哪怕你能让人开心一笑呢,就算是创造了情绪价值是不是。 当一个善良的好人,是对自己做人的标准,做一个好人不等于成功,这点基本认知要明白。 长大之后,一个痛苦的领悟就是,坏人不一定有恶报,但是没有能力,不会过得好。

人生就像打游戏,认知程度就是门槛。很多活法过了门槛才能解锁。解锁不了的人,就只能在低水平竞争层级玩,不知道上一层能玩什么。 如果你的工作是一个螺丝钉角色,并且你为了挣到一份更高的工资而学习的话,那结果是什么呢?结果是,你全部的学习,其目标都在变成一个更好的打工者。 换句话说,你只是在积累让你老板过得更好的能力,而没有积累让自己过得更好的能力。 终于有一天,你感受到,你的劳动能力正在随着时间的推移逐渐下降,你不能适应现在的工作了,你不能创造更多的价值了,你的经验很容易被复制。 做螺丝钉工作的知识边界太窄了,跟别人是重合的。于是:会引发激烈的竞争。低水平竞争的表现是什么呢?人踩人。因为不踩没有更好的办法。

其结果只有一个:你被更年轻、更便宜、更有精力的年轻人所淘汰,这是板上钉钉的事情。 如果你的问题是,上班很烦,自己没有竞争力,怎么才能竞争过年轻人呢。我想你首先要自检一下,自己所在的岗位是不是一个螺丝钉岗位(经验如果被复制的岗位)。 如果是,就别在这个小圈子里,琢磨怎么努力的事儿了,因为你努力的方向错了。 所以,去上班,绝不要当一个螺丝钉角色。 螺丝钉的命运只有2个:第一,你所在的这台机器老旧了,你跟着机器一起被淘汰;第二,你所在的这台机器被放弃了,你跟着机器一起被放弃。 你要很早就明白,上班是为了给自己时间,学习能让自己长期吃饭的本事和积累资源的,而不是为了挣一份工资。你要把自己看成是一项资产,你需要给自己时间让自己增值。 说两个起点一样,但对工作认知程度不一样的人物案例,主人公名字就叫傻傻和聪聪好了。傻傻和聪聪是大学同学,家庭背景,能力水平,都相差无几,都没有富老爸,都是男生。

傻傻觉得工作的意义就是挣工资过日子,傻傻觉得这事儿天经地义,没啥好说的。所以傻傻随便找了一份工作,当上了公司里的一枚螺丝钉,傻傻刚上班的时候,工资5000块,10年过去了,傻傻的工资涨到了9000块。 傻傻是个乐天派,他的人生理念是人生得意须尽欢,所以傻傻活得很潇洒,花钱大手大脚。 但是傻傻开始觉得干工作力不从心,高昂的生活开支让傻傻觉得很有负担,傻傻的孩子快出生了,但是傻傻没有太多存款,准备找家里老人帮帮忙,在公司,傻傻只能夹起尾巴做人,因为傻傻需要这份工作,离开这家公司,傻傻什么都不会。 聪聪觉得工作的意义是给自己一段时间积累能让自己长期吃饭的本事。聪聪家里有一次换房经历,他深知买房换房里面的坑太多,所以聪聪决定当一名房产经纪人,他认为这是能让他长期吃饭的本事。聪聪刚上班的时候,底薪2500块,每周只休息一天。 然后聪聪发现没有个人影响力,没有办法让自己获得超额收益,所以在做房地产经纪人的第五年,聪聪用了1年时间做准备,转行做了新媒体运营,匆匆的目的很明确,聪聪要学习如何积累自己的个人影响力。聪聪平时很节俭,把省下来的钱都用在自己的学习上了。

SEO的本质是内容销售,做seo其实就是做销售,做流量。 既然是做流量,那么方法就不仅仅是seo了,现如今,你要运营一个网站,只做seo,然后坐等排名上去,是几乎不可能的 最好的策略就是,不要刻意去做seo,用心做内容,正常去推广网站,给网站拿流量,通过分析用户行为,修改网站内容以达到更好的用户体验 等你网站流量起来了,你的seo排名自然也起来了 说白了,现在做seo你要以运营网站“品牌”的思维去做,不要想的是怎么去优化tdk,怎么植入关键词,关键词密度等等,这些不重要,重要的是你网站品牌“名气”和用户体验。

你观察如今很多排名非常靠前的网站,他们网站并没有过多的seo痕迹,排名靠前完全是因为网站“品牌”的影响力 近几年搜索引擎的算法,越来越倾向于行业类的“权威性”,要有权威性,就要先做打响知名度 光做seo就想获取流量的时代已经过去了,要不然那些所谓的“大神”也不会转型做培训和服务,既然他们可以几个月上首页,那么他们为什么要教别人做? 我有个朋友是在币圈某知名交易所上班,他们公司非常非常有钱,今年年初,他们花了100多w人民币,购买了一个国内seo服务,号称全是高手,通过各种黑帽手法,任何关键词可以1个月快速排名。当时我们就都觉得不靠谱,既然你能一个月,任何关键词都可以上首页,变现的手段那么多,何必给别人做服务。但是他们公司是非常大的企业,保不准这里面有没有人吃回扣,最终还是签了这个服务。结果半年过去了,通过seo来的注册不到10人。

在此也进一步证明,以前SEO的各种手法和技术,在如今搜索引擎的算法里,已经被淘汰了 想要做好SEO,就不要刻意去做SEO,还得是用心做内容,想办法获取流量,坚持不懈,说不定1-2年后,蓦然回首,那人却在灯火阑珊处

抓取配额指的是谷歌爬虫在一个域名中抓取页面所花费的时间和资源量。

优化您的网站非常重要,因为这样谷歌能更快地找到您的内容并对其进行索引,以此提高网站的可见度和流量。

如果您拥有包含数百万个页面的大型网站,那么管理抓取配额尤为重要,这将帮助谷歌更易抓到您网站的重要页面,并更好地理解页面的内容。

“如果您的网站没有大量快速变化的页面,或者您的页面在发布当天就被抓取,那么不断更新站点地图并定期检查索引覆盖范围就足够了。谷歌还规定必须对每个页面进行审查、整合和评估,以确定其抓取后的索引位置。

抓取配额主要由两个因素决定:抓取速度限制和抓取需求

抓取需求是指谷歌希望在您的网站上进行抓取的程度。较受欢迎的页面,例如CNN的热门报道和有显著变化的页面,会被抓取得更多。

谷歌爬虫希望在不给您的服务器带来过大负担的情况下抓取网站。为防止这种情况发生,谷歌机器人会计算抓取速度限制,即谷歌爬虫可用于抓取网站的最大并连数,以及抓取之间的时间延迟。

结合抓取速度和抓取需求,谷歌将抓取配额定义为谷歌爬虫可以且希望抓取的URL集合。即使未达到抓取速度限制,在抓取需求较低时,谷歌机器人也会减少对网站的抓取。

以下是管理大中型网站(拥有10,000个URL到数百万个URL)抓取配额的12个建议:

确定哪些页面重要,哪些页面不值得抓取(谷歌会较少访问不重要的页面)。

通过分析确定这一点后,就可以知道网站上哪些页面值得抓取,哪些页面不值得抓取,并将其排除在抓取范围之外。

例如,Macys.com有200多万个已编入索引的页面。

2023年6月,谷歌搜索 [site:macys.com] 的截图

该网站通过在robots.txt文件中通知谷歌不要抓取站点上的某些页面来管理其抓取配额。谷歌爬虫可能会认为不值得花时间查看网站的其他部分或增加抓取配额。因此要确保通过robots.txt文件阻止分面导航和会话标识符的访问。

虽然谷歌不会对重复内容进行处罚,但您还是希望向谷歌提供原创和独特的信息,以满足终端用户的搜索需求,并使其具有相关性和实用性。确保有使用robots.txt文件。

谷歌建议不要使用noindex标签,因为谷歌仍会请求但随后会放弃。

对于拥有数百万个页面的企业级网站,谷歌建议使用robots.txt文件来阻止抓取不重要的URL。

此外,您还要确保谷歌机器人和其他搜索引擎可以抓取您的重要页面、包含重要内容的目录以及关键页面。

如果可能的话,请保持较少数量的重定向。过多的重定向或循环重定向可能会使谷歌产生困惑,并降低抓取限制。

谷歌指出,长重定向链可能会对抓取产生负面影响。

使用HTML可以增加任何搜索引擎爬虫访问您网站的几率。

虽然谷歌机器人在抓取和索引JavaScript方面已经有所改进,但其他搜索引擎爬虫并不像谷歌那样复杂,因此可能会在HTML以外的其他语言方面出现问题。

确保您的网站对网站核心指标(Core Web Vitals)进行了优化。

您的内容加载速度越快(即三秒以内),谷歌就能越快地向终端用户提供信息。如果用户喜欢您的网站,谷歌将继续索引您的内容,因为您的网站显示出良好的谷歌抓取健康状况,也可能会因此增加您的抓取配额。

谷歌认为,内容是根据质量而非页面新旧评估的。必要时需要创建和更新内容,但通过微小的改动和更新页面日期来人为地让页面看起来更新并没有额外的价值。

如果您的内容满足终端用户的需求,那么新旧并不重要,只要它有帮助且相关即可。

如果用户认为您的内容没有帮助且无关,那么建议您更新和刷新内容,使其更新、相关且有用,并通过社交媒体进行推广。

此外,在主页增加链接到您的页面,这样可能增加重要性,被抓取的次数也会更多。

如果您删除了网站上的某些页面,请确保URL返回404或410状态,表示永久删除。404状态码表明将不再抓取该URL。

不过,被阻止的URL会在抓取队列中保留更长时间,并且将在阻止解除后被重新抓取。

此外,谷歌还规定要移除所有软404页面,这些页面将继续被抓取,浪费您的抓取配额。如要测试这一点,可以进入谷歌GSC并查看索引覆盖率报告,查找软404错误。

如果您的网站存在许多5xx HTTP响应状态码(服务器错误)或连接超时信号,抓取速度就会变慢。谷歌建议您密切关注搜索控制台中的抓取统计报告,并尽量减少服务器错误的数量。

另外,谷歌不会遵守非标准的“抓取延迟”robots.txt规则。

即使您使用了nofollow标签,但如果您网站上的其他页面或者任何其他页面未将该链接标记为nofollow,那么该页面仍可能被抓取,从而浪费抓取配额。

XML站点地图对于帮助谷歌发现您的内容并加快抓取速度非常重要。

以下几点至关重要:保持站点地图URL的更新,使用<lastmod>标签标记已更新的内容,以及遵循SEO最佳实践,包括但不限于以下几点:

仅包含您希望被搜索引擎索引的URL。

仅包含返回200状态码的URL。

确保单个站点地图文件不超过50MB或少于50,000个URL。如果决定使用多个站点地图,请创建一个索引站点地图,列出所有站点地图。

确保您的站点地图采用UTF-8编码。

包含指向每个URL的本地化版本链接。

及时更新站点地图,即每当有新的URL,或者旧的URL已更新或删除时,都要更新您的站点地图。

拥有良好的网站架构对于SEO排名和索引以及用户体验至关重要。

网站架构可以在多方面影响搜索引擎结果页面(SERP)的结果,包括抓取能力、点击率和用户体验。

拥有清晰的网站架构可以有效利用抓取配额,从而帮助谷歌机器人找到任何新的或已更新的内容。

请始终牢记三次点击规则,即任何用户最多点击三次即可从网站上的任何页面跳转到另一个页面。

网站越容易被搜素引擎抓取和浏览,抓取工具就越容易识别您的网站结构、上下文和重要内容。

建立指向某个页面的内部链接可以让谷歌知道该页面的重要性,有助于建立特定网站的信息层次结构,并有助于在整个网站中传播链接权益。

始终查看和监控GSC,以了解网站在抓取过程中是否存在任何问题,并寻找提高抓取效率的方法。

您可以使用抓取统计报告来查看谷歌机器人在抓取您的网站时是否遇到任何问题。

如果GSC报告了您网站的可用性错误或警告,请在主机可用性图表中查找谷歌爬虫请求超过红色限制线的情况,点击进入图表查看哪些URL存在问题,并尝试将其与您网站上的问题联系起来。

此外,您还可以使用URL Inspector工具来随机测试网站上的几个URL。

如果URL检测工具返回主机负载警告,这就意味着谷歌爬虫无法从您的网站中抓取到它所发现的多个URL。

由于大型网站规模庞大、结构复杂,因此抓取配额优化对于大型网站来说至关重要。

由于页面和动态内容众多,搜索引擎爬虫在高效抓取和索引网站内容方面面临挑战。

通过优化抓取配额,网站所有者可以优先抓取重要和更新的页面并编制索引,确保搜索引擎合理有效地利用资源。

这一优化过程包括改进网站架构、管理URL参数、设置抓取优先级和消除重复内容等技术,从而提高搜索引擎的可见度,改善用户体验,增加大型网站的有机流量。